在工业分拣、农业采摘、服务物流等领域,拾取机器人凭借精准的感知能力与灵活的操作性能,成为替代人工完成重复抓取任务的核心设备。无论是垃圾分拣中的快速分类,还是农业场景下的林木球果采集,拾取机器人都能通过视觉识别、运动控制等技术,高效处理多样化的抓取需求,同时降低人工劳动强度与成本。本文将从核心原理、物体识别训练方法、技术挑战三大维度,全面解读拾取机器人的技术细节与实践应用要点。

一、拾取机器人的核心原理:从感知到执行的全流程协同

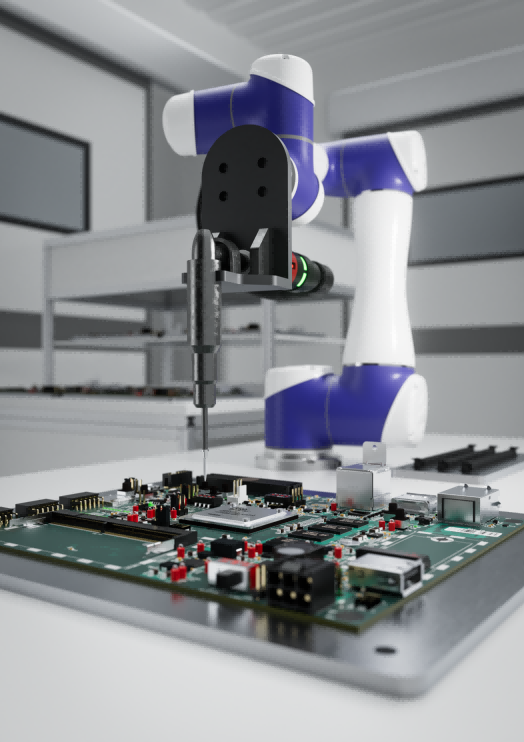

拾取机器人的工作流程围绕 “感知识别 - 运动规划 - 抓取执行” 展开,通过多系统协同实现精准、稳定的物体抓取,适配不同场景需求。

1.1 感知与识别系统:定位物体关键信息

感知系统是拾取机器人获取环境与物体信息的基础,主要通过视觉与多传感器融合实现:

视觉定位技术:搭载 3D 摄像头(如 RGB-D 相机)或激光雷达扫描作业环境,结合 YOLO、PointNet 等 AI 算法,精准识别目标物体的位置、形状及空间姿态,为后续抓取提供坐标依据;

多传感器融合:集成六维力 / 力矩传感器与触觉传感器,实时感知抓取过程中的力度反馈,实现抓取力度的自适应调节,避免因力度过大损伤物体(如易碎的玻璃制品)或力度不足导致物体脱落。

1.2 运动控制与抓取执行:实现灵活操作

运动控制与执行系统决定拾取机器人的操作精度与灵活性,核心包括路径规划与末端执行器设计:

机械臂路径规划:基于 D-H 运动学模型计算最优抓取路径,支持 5-7 自由度机械臂(如 UR5 协作机器人)完成复杂动作,例如绕过障碍物抓取料箱深处的物体;

末端执行器设计:根据抓取物体特性定制执行器,如平行夹爪适用于垃圾分拣中的块状物体,柔性梳齿适配林木球果等易损农产品,仿生手(如 MOGrip)可同时抓取多个小型物体并灵活传递。

1.3 智能决策与安全保障:提升作业可靠性

智能决策与安全系统是拾取机器人适应复杂场景、保障人机协作的关键:

智能决策技术:采用 MIT 提出的特征场建模(F3RM)技术,通过 NeRF 算法将 2D 图像特征投射到三维空间,支持自然语言指令控制(如 “抓取红色螺丝刀”);同时具备小样本学习能力,仅需 10-15 次人类示范即可适配新物体抓取任务;

人机协同安全:配备力反馈传感器与急停模块,当机械臂接触到人体或障碍物时,可实时触发碰撞检测并停止动作;部分林业拾取机器人还支持 VR 远程操控,结合环境感知系统实现高精度、安全的远程作业。

1.4 典型应用场景:覆盖多行业需求

拾取机器人已在多个领域落地应用,解决不同场景的抓取痛点:

工业分拣领域:垃圾分拣拾取机器人通过伺服电机驱动移动小车,机械臂抓取垃圾后按类别投放,作业效率较人工提升 5 倍,减少人工接触有害垃圾的风险;

农业采摘领域:林木球果采集拾取机器人采用 5 自由度机械臂,日均采集量达 500 公斤,物体损伤率低于人工采摘,降低农产品损耗;

服务物流领域:搭载仿生手(如 MOGrip)的拾取机器人,可在仓储场景中同时抓取多个包裹并灵活传递,提升物流分拣效率。

二、如何训练拾取机器人识别物体?数据与技术双驱动

拾取机器人的物体识别能力依赖科学的训练方法,需通过数据准备、算法优化、场景适配等环节,提升识别精度与泛化能力。

2.1 数据准备:合成数据与小样本学习结合

数据是训练拾取机器人识别物体的基础,通过多样化数据覆盖复杂场景:

合成数据生成:使用 Unreal Engine 4 等虚拟引擎创建 3D 场景,生成带精准标注的合成图像(如 Nvidia 已生成 12 万张合成数据),可模拟不同物体姿态、光照条件及极端情况(如倒置的杯子、倾斜的零件);该方式成本低、标注效率高,能弥补真实场景中罕见案例的数据缺失问题,为后续算法训练提供充足样本。

小样本学习与迁移学习:无需大量真实标注数据,通过少量人类示范(10-15 次)结合 3D 形状重建网络,让拾取机器人泛化到新物体抓取任务;例如天津大学提出的 Embodied-R1 框架,通过强化学习将视觉理解转化为动作执行,支持零样本迁移,大幅降低新场景的训练成本。

2.2 核心算法与技术:保障识别精度与效率

通过视觉算法与抓取规划技术,实现物体的精准识别与稳定抓取:

3D 视觉与物体识别算法:采用 RGB-D 相机或激光雷达获取物体点云数据,结合 PointNet、YOLO 等深度学习模型完成物体检测与位姿估计;同时引入动态 SLAM 技术(如 3DS-SLAM),过滤环境中的移动物体(如行人、工具车),减少干扰,提升抓取稳定性。

抓取规划与执行技术:结合分析法与数据驱动法制定抓取策略,例如通过力闭合多指手算法计算抓取稳定性,通过卷积神经网络预测最优抓取矩形;搭配视觉伺服控制(VS)技术,实时反馈物体位置变化并调整机械臂路径,确保抓取动作精准适配物体动态位置。

2.3 实际应用与优化:适配复杂场景需求

针对不同行业场景的特性,优化识别与抓取方案:

工业场景适配:面对高反光金属件(如汽车齿轮),采用多线激光结构光技术穿透反光干扰,定位精度可达 ±0.5mm;在无序分拣场景中,应用 MIT 的 “物体不可知” 抓取算法,无需提前学习物体特征即可处理未知物体堆叠。

动态环境应对:集成力反馈传感器与碰撞检测模块,在人机协作场景中保障作业安全;通过 HDBSCAN 聚类算法过滤 SLAM 系统中的动态点(如工人手臂),避免移动物体干扰物体识别结果。

2.4 训练工具与资源:降低技术门槛

为简化训练流程,行业内已形成成熟的工具与资源体系:

数据集:天津大学在 Hugging Face 平台开放的 Embodied-R1 数据集,包含多场景下的物体抓取样本,支持小样本学习训练;

框架与硬件:Nvidia 提供合成数据训练工具链,MIT 开发 3D 抓取算法库;硬件方面,推荐使用 UR5 协作机器人搭配海康 MV-DLS600P 3D 相机,兼顾精度与性价比。

三、拾取机器人识别物体的技术挑战:从感知到环境的多重难题

拾取机器人在物体识别过程中,需应对感知干扰、环境动态变化、技术瓶颈等多方面挑战,这些问题直接影响识别精度与作业效率。

3.1 感知层面挑战:解决识别失真与分割难题

反光与透明物体识别难题:反光表面(如金属勺、抛光零件)会导致 3D 相机点云失真,产生噪声或数据丢失,定位误差可能超过 1mm;透明物体(如玻璃杯)因光线穿透特性,3D 视觉易出现点云空洞,需结合多光谱成像技术增强物体轮廓识别。

复杂堆叠与遮挡问题:密集堆叠的小零件(如料箱中的螺丝、螺母)易导致点云粘连,需通过 PointNet++ 等深度学习算法分割目标物体;物体遮挡场景(如物料箱角落的零件)中,传统 3D 相机因视野局限可能漏检,需动态调整机械臂视角或采用多相机融合技术扩大识别范围。

3.2 环境动态性与适应性挑战:应对场景变化

动态场景干扰:人机协作场景中,工人手臂、移动工具车等移动物体会干扰 SLAM 系统,导致物体位置判断偏差;需通过 HDBSCAN 聚类算法过滤动态点云数据,仅保留静态目标物体信息,确保识别稳定性。

光照与材质多样性影响:高反光金属件需多线激光结构光技术穿透反光干扰,深色吸光材料(如橡胶制品)需增强红外补光才能生成清晰点云;长期部署场景中,环境变化(如仓库货架移动、农业大棚光照变化)要求拾取机器人具备终身学习能力,通过 OpenLORIS-Scene 等数据集持续优化识别模型。

3.3 技术实现瓶颈:平衡实时性与泛化能力

实时性与算力限制:高分辨率 3D 相机(如 Zivid Two)生成的点云数据量大,处理时需高性能 GPU 支持,若算力不足,数据处理延迟可能超过 200ms,导致抓取动作滞后,影响作业效率;

小样本泛化能力不足:新物体识别需大量标注数据训练模型,虽小样本学习框架(如 Embodied-R1)可减少数据依赖,但面对极端形状物体(如不规则塑料件)时,泛化精度仍需提升。

3.4 解决方案与发展趋势:多技术融合突破

多模态融合技术:结合视觉、力觉、触觉传感器(如 UR5 协作机器人的力反馈系统),通过多维度数据互补提升识别鲁棒性,例如力觉传感器可辅助判断透明物体是否抓取稳定;

合成数据训练普及:通过 Unreal Engine 等虚拟引擎生成覆盖极端工况(如倒置物体、破损零件)的合成数据,降低真实场景数据采集成本,同时提升模型对复杂场景的适配能力。

四、拾取机器人应用案例(数据支撑)

某垃圾处理厂此前采用 8 名人工进行垃圾分拣,存在三大问题:一是效率低,人工每小时仅能分拣 150 公斤垃圾,无法匹配日均 50 吨的垃圾处理需求;二是分拣精度低,可回收垃圾误分率达 18%,造成资源浪费;三是作业环境差,工人长期接触有害垃圾,呼吸道疾病发病率达 12%。

后引入垃圾分拣拾取机器人(搭载 RGB-D 3D 相机 + UR5 协作机械臂,配备平行夹爪),通过以下优化实现效率与精度双提升:

效率提升:拾取机器人每小时可分拣 600 公斤垃圾,4 台设备即可替代 8 名人工,垃圾处理量从日均 30 吨提升至 50 吨,满足工厂满负荷运行需求;

精度改善:通过 PointNet 算法优化物体识别,可回收垃圾误分率从 18% 降至 3%,每月增加可回收资源收益约 2 万元;

环境与成本优化:工人无需直接接触垃圾,呼吸道疾病发病率降至 0;设备一次性投入 68 万元,年维护成本约 4 万元,相比人工年薪资支出 64 万元,每年节省成本 60 万元,1.1 年即可收回投资。

五、FAQ 问答

问:拾取机器人如何识别透明物体(如玻璃杯)?传统 3D 视觉存在点云空洞问题该如何解决?答:识别透明物体需采用 “多技术融合” 方案:一是结合多光谱成像技术,通过不同波长光线的折射差异增强透明物体轮廓;二是搭配触觉传感器,当 3D 视觉点云空洞时,通过机械臂轻触感知物体边界;部分高端方案还会在透明物体表面添加微弱反光标记,辅助 3D 相机定位,可将识别误差控制在 ±0.5mm 以内。

问:中小工厂预算有限,训练拾取机器人识别新零件时,如何降低数据采集成本?答:建议优先采用 “合成数据 + 小样本学习” 组合方案:使用 Unreal Engine 生成虚拟零件的 3D 场景数据(成本仅为真实数据的 1/10),覆盖零件不同姿态与光照;再通过 Embodied-R1 等小样本框架,仅需 10-15 次真实零件抓取示范,即可完成模型迁移训练,无需大量标注真实数据,整体训练成本可降低 60% 以上。

问:在人机协作场景中,拾取机器人如何避免被工人手臂等移动物体干扰识别?答:可通过 “动态点过滤 + 实时监测” 解决:一是在 SLAM 系统中集成 HDBSCAN 聚类算法,实时分析点云数据,过滤工人手臂、移动工具等动态点,仅保留静态目标物体;二是配备安全光幕,当工人进入机器人作业半径时,自动降低机械臂运行速度并增强碰撞检测灵敏度,既避免识别干扰,又保障人机安全。

问:拾取机器人处理高反光金属零件时,3D 相机点云失真导致抓取偏差,该如何优化?答:优化方案主要有三点:一是更换多线激光结构光 3D 相机(如海康 MV-DLS600P),激光穿透反光层获取清晰点云,减少失真;二是在金属零件表面喷涂临时哑光涂层(不影响零件性能),降低反光率;三是通过算法优化,对失真点云进行降噪与补全,结合力反馈传感器实时调整抓取姿态,可将抓取偏差从 ±2mm 降至 ±0.5mm。

版权声明:本文内容由网络用户投稿,版权归原作者所有,本站不拥有其著作权,亦不承担相应法律责任。如果您发现本站中有涉嫌抄袭或描述失实的内容,请联系我们jiasou666@gmail.com 处理,核实后本网站将在24小时内删除侵权内容。